Központi szervertermünkben az infrastruktúra része a free cooling rendszer.

A szerverek hőt termelnek, egyesek többet, mások kevesebbet. Ezt a hőt el kell vezetni a processzor és más hőtermelők felszínéről, különben a szerver túlmelegszik, és lekapcsol. A hűtés pedig egy adatközpontnak jelentős többletkiadást jelent, hiszen egy jelentős árammennyiséget nem is számításra, tárolásra vagy adattovábbításra használ, hanem arra, hogy az egész rendszer megfelelő hőmérsékletű legyen. Környezettudatos szempontból erre a free cooling az egyik legjobb megoldás.

Arról megoszlanak a vélemények, hogy hány fokon kell tartani a szervereket, mennyire kell lehűteni őket. Itt néhány fok is sokat számít, éves viszonylatban. Főleg nyáron, amikor a mérsékelt övben is elég meleg odakint a levegő, ami miatt nagyon nagy teljesítményeket kell bekapcsolni, hogy ugyanazt a hideget elérjük odabent.

Nem véletlen, hogy vannak központok, amiket olyan országokba telepítettek, ahol általában ilyen meleg nincs, sőt, az év nagy részében a külső, természetes levegő beszívásával is el lehet érni a szervereknek megfelelő hőmérsékletet. Ez a freecooling: nem kapcsol be a hűtőgép, nem áramlik a hűtőfolyadék, csak a ventilátorok kapcsolgatnak, és a hőmérők adatai alapján gyorsítják, vagy lassítják az áramlást.

A PUE (Power usage effectiveness, vagyis energiafelhasználási hatékonyság) egy adatközpontokra jellemző érték. Azt mutatja meg, hogy hány Watt energiát használ fel a központ ahhoz, hogy egyetlen Watt energia jusson a számításra, vagyis maguknak a szervereknek. A PUE a legjobb mérőszáma egy szerverterem energiahatékonyságának, hiszen egyáltalán nem arra koncentrál, hogy maguk a szerverek mennyire hatékonyak (arra van más mérő). Inkább arra kíváncsi, hogy minden, ami nem szerver – vagyis UPS, kapcsolók, egyéb eszközök és persze hűtés, vagyis a terem – mennyit dob rá a szerverek fogyasztására.

Ha például az arányszám 2, akkor a szerverekhez jutó minden egyes Wattra két Wattnyi energiát kell előállítani, kifizetni az üzemeltetőnek. Minél közelebb van az arány a 1-hez, annál hatékonyabb a szerverterem.

2008 októberében a Google adatközpontjai 1.21-es PUE-val büszkélkedtek. 2015-ben a Switch, ami a SUPERNAP adatközpont fejlesztője, 1.18-at ért el Las Vegasban. A Facebook prineville-i adatközpontja pedig már 1.078-es PUE-t ért el, vagyis csaknem minden energiát sikerült nekik a szervereknek adni. Ez már hihetetlen szám.

A Rackforest Victor Hugo utcai termében 1,1 és 1,3-as PUE között vagyunk. Sokan nagyot néznek, amikor meghallják ezt a számot, hiszen egyáltalán nem könnyű elérni ezt. Hogy sikerült? Természetesen freecoolinggal, mégpedig nagyon jól eltalált freecoolinggal.

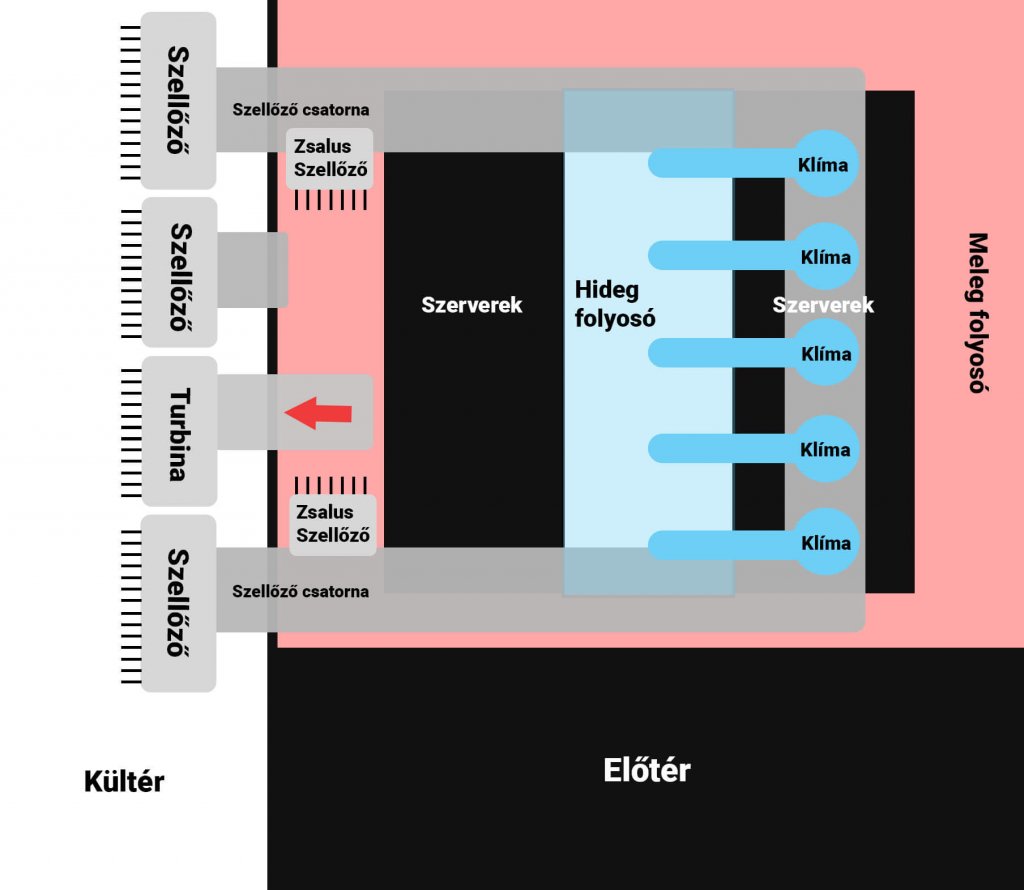

A fenti ábrán látható egyszerűen lerajzolva a rendszer. Nyáron a szerver teremben lévő meleg levegő a szellőzőn keresztül bejut a klímákba, ami a hőcserélővel lehűti azt és ventillátorokkal a hideg folyosóba juttatja. Télen a kültéri szellőzőnyílásokon keresztül juttatunk a szellőzőcsatornába hideg levegőt, amit a klíma ventillátorok juttatnak a hideg folyosóra. Amennyiben a kültéri levegő hőmérséklete túl hideg a zsalus szellőzők részleges megnyitásával engedünk a meleg folyosóról magasabb hőmérsékletű levegőt a szellőző csatornába így szabályozva a hőmérsékletet. További érdekesség, hogy a meleg folyosóról free cooling esetén egy turbina segít kijuttatni a levegőt.

Így van, nemcsak a térítőktől a sarkok felé érdemes freecoolingot használni, hiszen Magyarországon is rengeteg olyan óra adódik egy évben, amikor a kinti hőmérséklet tökéletesen elég a szerverek ellátására. Ez a határ a 18 Celsius fok: e felett bekapcsolnak a hűtőgépek, és csak a benti levegőt keringetik. Ez is nagyon energiatakarékos – ahogy a PUE-ból látszik -, hiszen hideg-melegfolyosós a kialakítás, és a melegfolyosóra ömlő levegő energiáját is felhasználjuk. 18 fok alatt azonban kikapcsolnak a kültéri klíma gépek, kinyitnak a kifelé néző zsaluk, és elkezdődik a ventilátorok tánca. A beömlő levegő mennyiségét szabályozzuk, ahogy egy plusz zsalut is nyitogat-zárogat a rendszer: ez kever bele meleg levegőt a kintről érkező hidegbe, ha kell.

A klímagépek rendszere N+1-re méretezett. Ez azt jelenti, hogy négy gép képes ellátni a teljes terem szükségletét, ha maximumon mennek, de nálunk nem négy, hanem öt megy egyszerre. Azért, hogy ha egy kipurcan, akkor is működjön a rendszer freecoolingban. Ilyenkor általában megkérdezik, hogy mi van, ha kettő purcan ki. Ez a méretezés lényege: ha N+2-t alakítunk ki, az nagyobb rendelkezésre állást, azonban nagyobb PUE-t és magasabb árakat is jelent. Az N+1 éppen az, ami pont jó az ügyfeleinknek, és természetesen georedundanciával könnyedén lehet növelni tovább a rendelkezésre állást, ha a költségek lehetnek magasabbak (több fizikai szerver több ponton, így egy teljes központ kiesése sem jelent problémát).

Ránk azonban jellemző, hogy itt nem álltunk meg. Ránk az jellemző, hogy egy rendszer kiépítésénél szeretünk olyan trükköket bevetni, amik a kialakításnál nem jelentenek nagy befektetést, viszont jelentősen növeli később a redundanciát (ilyen például az a trükk, hogy egymást kiváltó eszközöknél sosem veszünk ugyanabból a szériából származó tételeket, hiszen azok egyszerre is mennek majd tönkre). Itt is így volt, megkerestük a magunk megnyugtatását.

A klíma központi egysége nálunk például nem mindenható. Semmi kedvünk nem volt ahhoz, hogy a központ meghülyülése esetén az N plusz akárhányas rendszerünket dobhassuk a levesbe. Hiszen ha a vezérlés nem jó, akkor semmi sem az. Ezért aztán a központ nálunk egy setpointot ad a gépeknek, külön-külön. A gépek saját maguk is tudják, hogy mi a minimális és maximális setpoint, vagyis hülyeséget eleve nem is fogadnak el a központtól. Miután pedig megkapják az utasítást, onnantól önállóan dolgoznak, a központ akár össze is omolhat, akkor is meg tovább a munka a megadott setpoint felé, hiszen minden klímagépnek külön vezérlése van. Ha leáll a központ, és az egyik klíma, akkor a másik három érzékeli, hogy melegednek, és rákapcsolnak: az élet megy tovább.

További kérésünk volt, hogy minden gépnél legyen két darab fizikai kapcsoló. Az egyik On/Off, a másik Full Freecooling / Full Cooling. Ez azért kell, mert ha mégis bonyolultabb lenne a baj, mint amire számítunk, akkor is be tudunk avatkozni kézzel, és felülírni bármilyen megtébolyult működést, annak megfelelően, hogy milyen hőmérsékleteket látunk odakint, a szerverterem hideg- és melegfolyosóján.

Nagyon büszkék vagyunk erre a teremre, mert a PUE, a biztonság és az ezért fizetendő ár szerintünk nagyon-nagyon el lett találva, és nem kis munkánk volt abban, hogy így legyen.